A szentimentelemzés vagy polaritásmérés az utóbbi öt évben rendkívül felkapott lett - mi is imádjuk. De mindig akad egy de! Ma két iskola működik, az egyik az ún. szótáras, a másik pedig a klasszifikációs módszer híve. Mindkettőnek megvannak a maga erősségei és gyengéi is. Jó hír: talán akad jobb!

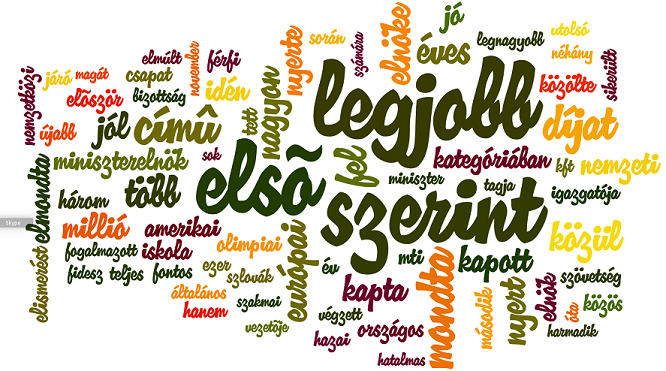

A klasszifikációs módszer lényege, hogy egy sok-sok példát tartalmazó korpuszt készítünk, ami felsorol sok negatívnak, pozitívnak ill. semlegesnek ítélt mondatot. Ilyen pl. Miháltz Márton remek OpinHuBank korpusza a magyar nyelvre. Nézzük meg a leggyakoribb szavakat a pozitív példákból!

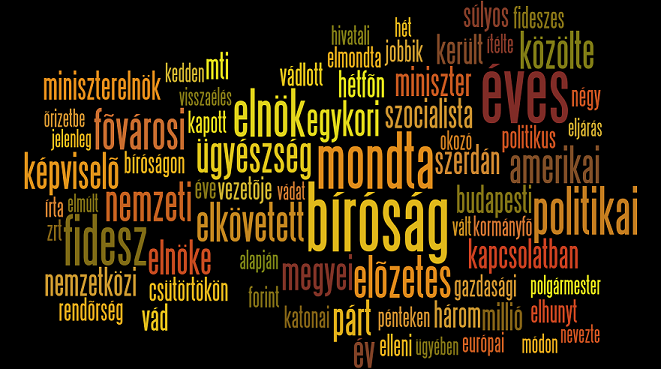

Vessünk egy pillantás a negatív példák leggyakoribb szavaira is!

Reméljük két dolog egyből látszik:

- a példák híroldalakról és blogokról származnak

- nagy az átfedés a leggyakoribb szavak között

Nyilván a klasszifikációt végző algoritmus (általában naív Bayes, vagy annak valamilyen változata) nem ezen szavak alapján dönti el, hogy melyik osztályba soroljon egy-egy mondatot, hanem a gyakorisági listán hátrébb szereplő szavakat vizsgálgatja. Csakhogy ezek vagy nagyon területspecifikusak, vagy túl általánosak. Éppen ezért a tanuló algoritmusokon alapuló szentimentelemzők általában spéci, az adott területhez készített korpuszt használnak.

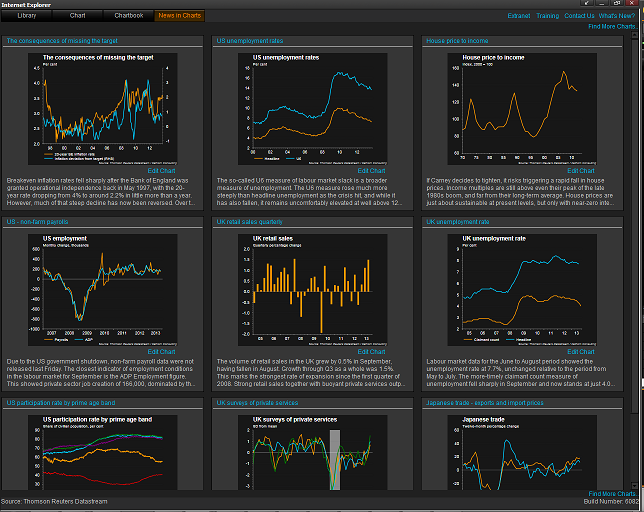

A másik iskola szótárakat használ, melyek inkább szólisták egy-egy adott szentimenthez. Az "elemzés" lényege az, hogy megszámolják az elemzett szövegben a listákon szereplő szavak arányát. Itt gondot szokott okozni a tagadás (pl. az "Ez a könyv jó" és az "Ez a könyv nem jó" mondatok polaritása tutira ellentétes a tagadás miatt) és egyéb finomságok. Persze ezek jelentős részét lehet kezelni valamennyire, viszont itt is a területspecifikusság problémája merül fel (ennek legtöbbet idézett írása a pénzügyi területen született When is a Liability not a Liability? Textual Analysis, Dictionaries, and 10-Ks tanulmány). Érthetőbben pozitív-e a növekedés? Ha nő a cégünk az pozitív, de ha nő a költségvetés hiánya, az bizony aggasztó (persze pl. egyes keysiánusoknál ez megint lehet pozitív polaritású is).

A kérdés az, akad-e általános eszköz szentimentelemzésre? Blogunkon már többször foglalkoztunk Pennebaker megközelítésével, ami a hagyományos stopszószűrés után megmaradó tartalmas szavak elemzése helyett a funkciószavak arányaira figyel. A Counting Little Words in Big Data c. riportban Pennebaker és szerzőtársa remekül összefoglalja milyen lehetőségek rejlenek ebben a megközelítésben. A funkciószavak ugyanis nem nagyon változtatják jelentésüket a különböző regiszterekben - reméljük, hogy egy jogász ugyanazt érti alatta, mint én és a háziorvosom. A megközelítés további előnye, hogy nem csak a lassan szűkössé váló pozitív, semleges, negatív osztályozást, hanem az emócióelemzést, sőt a beszélők szegmentálását is lehetővé teszi! (L. erről a blog egyik szerzőjének Twitter-fiókján végzett elemzésünket.) Úgy tűnik érdemes számolni a szavakkal!