A technikának hála ma már szinte korlátlan mennyiségben tudunk adatokat gyűjteni, tárolni és elemezni. Azonban a big data kapcsán kevesen veszik maguknak a fáradtságot arra, hogy metodológiai kérdéseken mélázzanak el, a kevés kivétel is általában Anderson The End of Theory: The Data Deluge Makes the Scientific Method Obsolete című írásához hasonló álláspontra jutva amellett érvel, hogy a hatalmas adatmennyiség feleslegessé teszi az elméleteket. A helyzet ennél sokkal bonyolultabb, mivel a big data általában a viselkedés- és társadalomtudományok területére téved, hiszen emberekről (felhasználókról, fogyasztókról) próbál megtudni minél többet.

Abban mindenki egyet szokott érteni, hogy a big data minőségi változást hozott a tudományba, a Hey és tsai által szerkesztett The Fourth Paradigm: Data-Intensive Scientific Discovery című kötet kapcsán egyenesen egy új paradigmáról beszélnek egyesek. Hal R. Varian Big Data: New Tricks for Econometrics című összegző tanulmánya ellenben rávilágít arra, hogy a big data alkalmazása nem ér fel egy tudományos forradalommal.

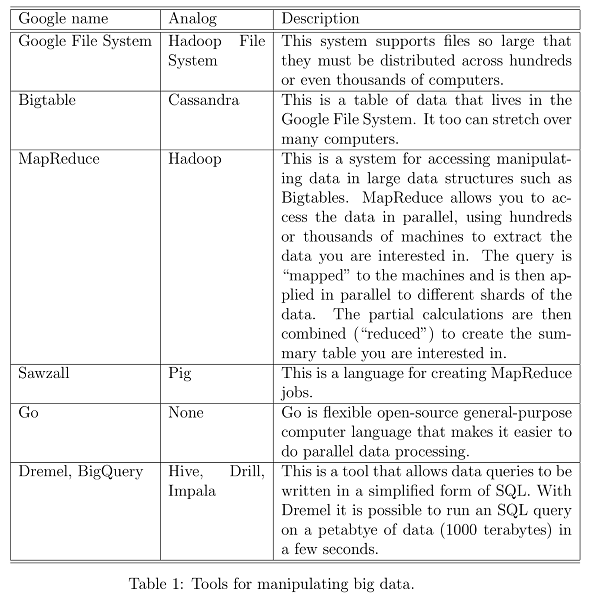

Miképp az írásból is kitűnik, a számítógépek alkalmazása az ökonometriától sem áll távol s a big data eszköztárát a szerző "hagyományos" szoftverekkel veti össze. További érdekesség, hogy a nagy adathalmazok elemzéséhez a bevett regressziós modellekhez hasonlókat ajánl (regression like methods). Úgy tűnik, a gyakorló társadalomtudós az új adatgyűjtési és -elemzési módszereket a már meglévő eljárások kiterjesztésének tekinti, s a minőségi ugrást nem a technológiától, hanem annak használatától várja.

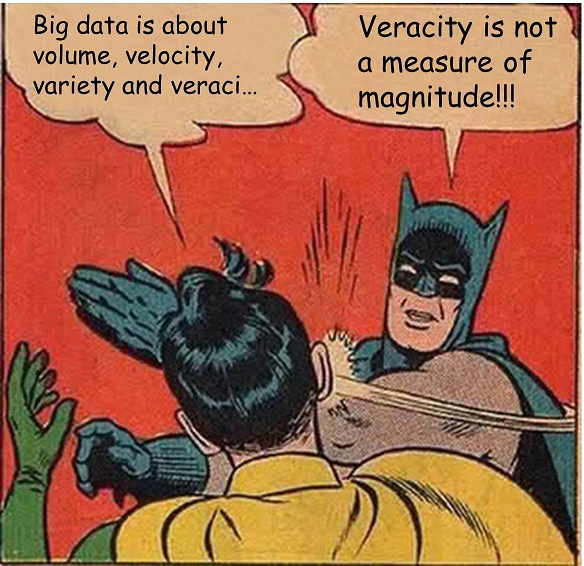

De akkor mégis, milyen hatása van a big data megjelenésének a tudományos módszerre? A kérdésre Wolfgang Pietsch Big Data - A New Science of Complexity című tanulmányában próbált válaszokat találni. A 19. században kialakult és máig bevett ún. tudományos módszertől Pietsch szerint a big data négy alapvető kérdésben tér el:

- a gyűjtött adatok sok paraméterét vizsgálja

- egyszerű funkcionális összefüggéseket keres

- alkalmazása minden esetben behatárolt

- nem alkot összefüggő, univerzális elméleteket

Behatároltsága ellenére ugyanakkor sokkal sikeresebb lehet, mint egyes szofisztikált elméletek. A beszédfelismerésben Jelinek mondása, "Every time I fire a linguist, the performance of the speech recognizer goes up", példázza legjobban ezt. A nyelvészetben gyönyörű elméleteket lehet alkotni, akár csak egy karosszékben ülve, vagy egy beszédlabort használva. Ezek az elméletek nagyon hasznosak, csak sajnos a beszédfelismerésben nem használhatóak. Ellenben viszonylag primitív matematikai módszerek kellően nagy adatmennyiségen alkalmazva sokkal eredményesebbnek bizonyultak a nyelv feldolgozásának különféle területein. (Peter Norvig és tsai The Unreasonable Effectiveness of Data című írásukban több olyan területről is hoznak példát, ahol az adat intenzív megközelítés az elméletépítésnél sokkal gyümölcsözőbbnek bizonyult.)

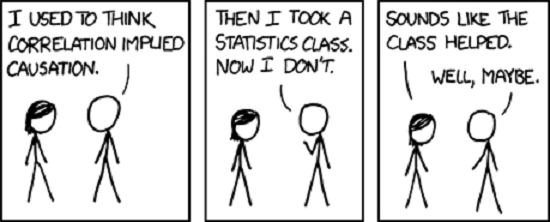

Kicsit úgy tűnik, a big data meghozta az igazi posztmodern tudomány korát! Vége a nagy elméleteknek, és Feyerabend anything goes megközelítése győzedelmeskedik - akinek ez az értelmezés nem tetszik, az fogadja el, hogy a big data nem hozott új paradigmát, lokális területeken győzött, de még várnunk kell az áttörésre (ha egyáltalán lesz). Érdemes még a társadalomtudományok felé fordulni, akik rég letetettek a mindent megmagyarázó egységes elmélet megtalálásáról és a statisztika mellett olyan szavakkal operálnak mint verstehen, azaz a vizsgált alanyok (emberek, fogyasztók, felhasználók) megértése.