Június 10-én tartott céges Hackathonunkon az egyik csapatunk egy igazán izgalmas projekten, multimodális emócióelemzésen dolgozott.

A feladathoz rövid, angol és magyar nyelvű videórészleteket kerestünk. Olyan anyagokra volt szükségünk, ahol a kép, a hang és a szöveg is jó eséllyel elemezhető emóciókat mutat. Végül három videórészlet maradt fent a rostán: az angol nyelvre a Bladerunner Tears in rain monológja és a Closer egy jelenete, a magyarra pedig a Beugró Váltóláz nevű játékából egy részlet.

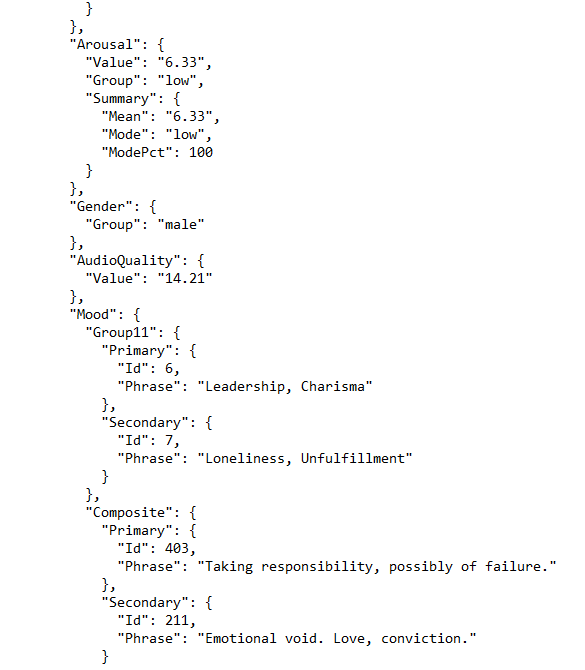

Első lépésként a videókat két perces anyagokra vágtuk, mert az API, amellyel a hangsávot elemeztük, csupán két perces anyagot fogad. A hangsáv elemzésével az alábbihoz hasonló eredményt kaptunk:

Azokat az emóciókat, amelyeket a hangsávon felismertünk, felvittük a videóra annotációként. A női beszélők érzelmei rózsaszínű, a férfi beszélőké pedig kék szövegbuborékokba kerültek.

A vizuális emóciók feldolgozását szintén egy API segítségével végeztük. Első körben a Google Cloud Vision-jét próbáltuk ki, de az számunkra nem bizonyult megfelelőnek. A képi anyag elemzési eredményeit szintén felvittük a videókra.

Az eredményeink alább nézhetőek meg:

A magyar nyelvű videónkon az emóciószótáraink segítségével még szövegelemzést is végeztünk a hang és a kép feldolgozása mellett. Ez lett az eredmény:

A projekt eredményeivel és tapasztalataival a hátunk mögött most meg szeretnénk vizsgálni, hogy milyen összefüggésben van a három különböző típusú elemzés egymással. Azt gondoljuk, hogy egy multimodális elemzésben a három elemzési eszköz hatékonyan kiegészítheti egymást, és olyan emóciókat is megmutathat, amelyek a csak az egyik faktort figyelembe vevő elemzésben elvesznének. További terveink között szerepel annak feltérképezése is, hogy mit árul el a multimodális elemzés olyan trükkös jelenségek esetében, mint a hazugság, a káröröm, az irónia vagy a gúny.