Eddig, amikor a mesterséges intelligencia valamilyen “műalkotást” készített, az emberek adták ahhoz a kreatív szikrát, éppen ezért azok a félelmek, miszerint a mesterséges intelligencia eszközök kiválthatják az olyan művészi területen dolgozó emberek munkáját, mint az illusztrátorok, tervezők és fotósok, egyelőre megalapozatlannak tűntek. Egyelőre…

Veszély a láthatáron?

Az idei év áprilisában, amikor az OpenAI, mesterséges intelligenciával foglalkozó vállalat bejelentette a DALL-E 2 elnevezésű új szolgáltatását, egyúttal figyelmeztetett arra is, hogy „a modell növelheti bizonyos feladatok végrehajtásának hatékonyságát, mint például a fotószerkesztés vagy a stock fotózás, ami kiszoríthatja a tervezők, fotósok, modellek, szerkesztők és művészek munkáját”.

Egy-egy ilyen új, mesterséges intelligencián alapuló termék megjelenése esetén már megszokott, hogy újra és újra szárnyra kapnak azok az elképzelések és vélemények, amelyek szerint ezek a megoldások veszélyeztetik az adott területen tevékenykedő emberek munkáját és megélhetését. De mi a helyzet a DALL-E 2 esetében?

Ösztönzött kreativitás

Néhány szerencsés ember már kipróbálhatta a megoldást, amely képes utasítások alapján képi tartalmakat generálni. A használat során azonban az derült ki, hogy a "gép" által készített grafikai produktumok nemhogy szükségtelenné tennék az emberi kreativitást, hanem kimondottan ösztönzőleg hatnak arra. Erről árulkodnak többek között az egyik felhasználó, Benjamin Von Wong, egy installációkat és szobrokat készítő művész szavai is, aki saját bevallása szerint - meglepő módon bár, de - igen gyenge képességű rajzoló :

„A DALL-E egy csodálatos eszköz olyanok számára, mint én, akik nem tudnak rajzolni...a képi tartalmakat egyszerűen generálhatom különböző felszólító kifejezésekkel...az eszköz segítségével pedig olyan ötleteket kutathatok fel, amelyek később fizikai műalkotásokba építhetők be."

a képzelet szárnyra kap - akár a mesterséges intelligencia által generált képi tartalmaktól is

A DALL-E 2 tehát ugyan kivált(hat) bizonyos, eddig az ember által elvégzett feladatokat, mégis a létrehozott, finoman szólva gyakran egyedi képi alkotásaival új ösztöntést ad az emberi képzeletnek és kreativitásnak, így nem a "végterméket" hozva létre, hanem egy köztes tartalmat, amelyre alapozva tovább építhet az emberi alkotó.

hagyományos eszközöket is használhatunk kreativitásunk kiéléséhez

Homályos a jövő

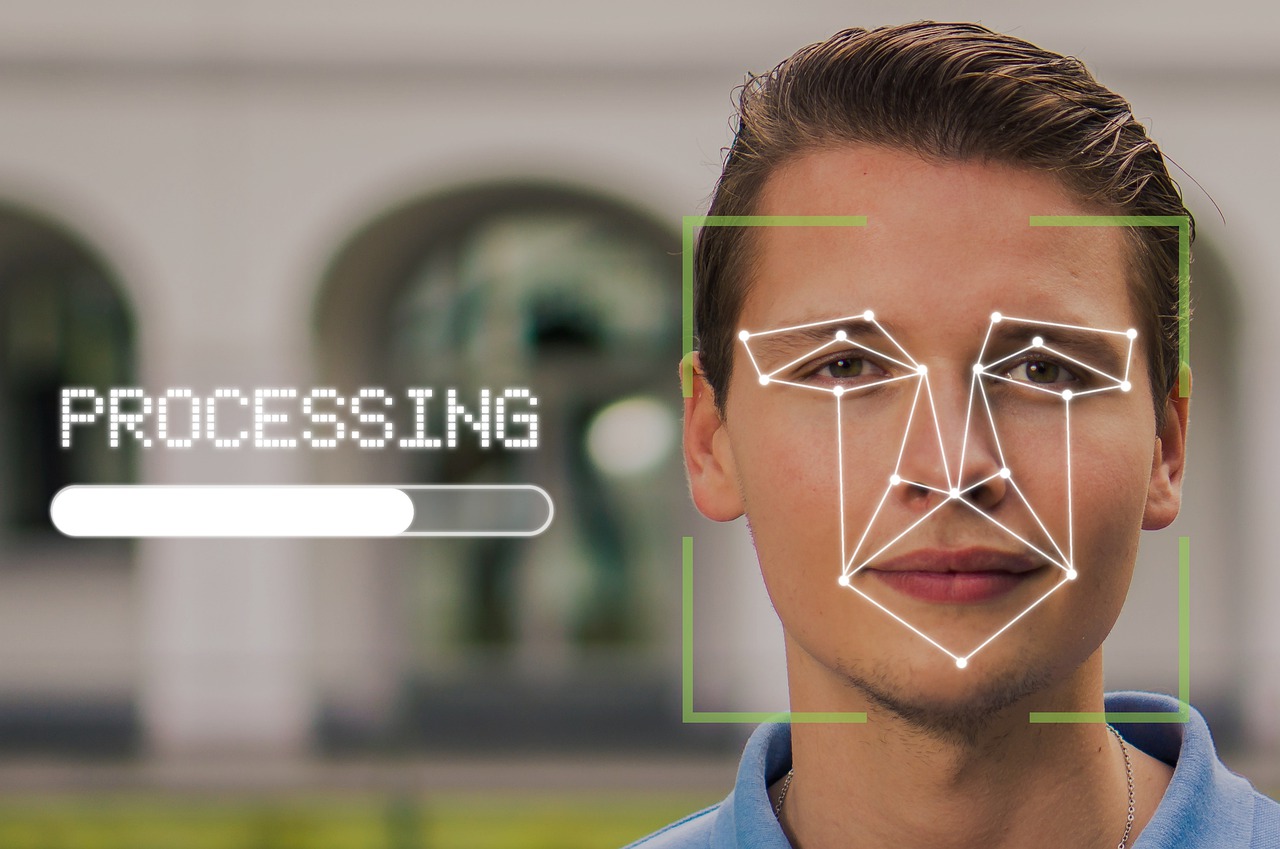

Egyelőre még nem tudható, hogy egy ilyen technológia végül milyen hatással lesz az illusztrátorokra, fotósokra, más kreatívokra, illetve munkájukra. Jelenleg még túlzó leegyszerűsítésnek tűnik az az elképzelés, hogy a művészi mesterséges intelligencia eszközök kiszorítják a dolgozókat a kreatív munkákból – ahogyan például néhány esetben az ipari robotok "veszik el" a gyári dolgozók munkáját. Annál is inkább igaz ez, mivel az ipari termelésben is elsősorban a viszonylag egyszerű, ismétlődő feladatokat hajtják végre ezek az eszközök.

az ipari robotok főként egyszerű és ismétlődő feladatok elvégzésére lettek tervezve

Természetesen a robotok és a mesterséges intelligencia bevonásával "dolgozó eszközök" vállalatok általi alkalmazása alacsonyabb foglalkoztatást és béreket eredményez(het), de most már arra is van bizonyíték, hogy bizonyos körülmények között a robotok növelik a munkalehetőségeket - például az emberi kreativitás ösztönzésével.

Ezt erősíti meg egy másik vélemény is:

„Egyesek túl könnyen feltételezik, hogy a gépek helyettesíthetik az emberi kreatív munkát...a művészeti alkotások létrehozása rendkívül bonyolult folyamat, amire a gépek még nem állnak készen.” – mondja Noah Bradley, digitális művész, aki oktatóanyagokat tesz közzé a YouTube-on az AI-eszközök használatáról.

Mindenesetre érdemes nyomon követni a mesterséges intelligenciával kapcsolatos híreket, a területen végbemenő változásokat és az újdonságokat, legyen szó akár munkaerőpiaci vagy kreatív megközelítésről.

Amennyiben többet szeretne megtudni a témáról, kérjük olvassa el a Wired oldalán megjelent angol nyelvű cikket, amely jelen blogbejegyzésünk alapjául is szolgált!