Philip K. Dick kérdését tovább is gondolhatjuk; vajon egy android, vagy egy mesterséges intelligencia érezhet-e fájdalmat? Lehet-e a közeli jövőben egy gép a barátunk? Elkalandozunk az elmefilozófia, a pragmatika és a dinamikus episztemikus logika világába a válaszért!

Intenciók

Habár napjainkban rengeteg kritika éri, máig a legismertebb teszt az emberi intelligencia vizsgálatára a Turing-teszt. Az ún. imitációs játék végén akkor tekinthetünk egy programot intelligensnek, ha sikerül meggyőzni a humán zsűri egy jelentős részét arról, hogy emberrel beszélgetett. A kritikák helyett inkább két dolgot emelnénk ki ebből

- a teszt során beszélni kell, akár szóban, akár egy szöveges interfészen keresztül

- embereket kell meggyőzni arról, hogy egy emberrel beszélgetnek

Daniel Dennett szavaival élve, intencionális alapállás felvételére kell "kényszeríteni" a zsűrit. Dennett Az intencionális rendszerek című esszéjében sorra veszi milyen alapállásból próbálja meg az ember értelmezni a vele szembekerülő dolgokat, azaz a világot, s három ilyet talál.

- tervezet-alapállás: "Ha pontosan tudom, hogyan tervezték meg a komputert (beleértve a tervezet nem állandó részét, a programot is), akkor a program komputációs utasításait követve bejósolható a komputer bármely lépésre betervezett válasza. Jóslatunk be fog igazolódni, amennyiben a komputer a tervezetnek megfelelően működik, vagyis nem romlik el. A tervezet-alapálláson alapuló bejóslásoknak különböző változataik vannak, mindegyik hasonlatos azonban a tekintetben, hogy a funkció fogalmára támaszkodnak, mely célfüggő vagy ideologikus."

- fizikai hozzáállás: "Erről az alapállásról nézve predikcióink az adott tárgy tényleges fizikai állapotain alapulnak, s a természeti törvények ismeretéből kiindulva alkotjuk meg őket. Ez a hozzáállás szükséges a rendszerek rosszul működésének bejóslására."

- intencionális nézőpont: "Ilyen esetben a viselkedést úgy jósoljuk be, hogy a rendszerhez bizonyos információ birtoklását rendeljük hozzá, s feltételezzük, hogy bizonyos célok irányítják, s azután e hozzárendelések és feltevések alapján kidolgozzuk a legésszerűbb s a legmegfelelőbb cselekvést."

Fontos megjegyezni, hogy az intencionális nézőpont egy stratégia, nem kell feltétlenül intelligens ágensnek lennie annak amit ebből szemlélünk, ahogy Dennett mondja:

Így nincs helye itt azon sopánkodni, hogy vajon a sakkozókomputernek tényleg vannak-e vélekedései és vágyai; az intencionális rendszerekről adott meghatározásunk ugyanis nem állítja azt, hogy az intencionális rendszereknek tényleg vannak vélekedéseik és vágyaik, csak annyit mond, hogy viselkedésüket meg lehet magyarázni és be lehet jósolni úgy, hogy vélekedéseket és vágyakat rendelünk hozzájuk. Annak pedig, hogy amit a számítógéphez rendelünk, vélekedésnek nevezzük, vagy a vélekedés analógjának, vagy információs komplexumoknak, vagy intencionális micsodáknak, nincs következménye azokra a számításokra nézve, melyeket a hozzárendelés alapján végzünk. Ugyanazokra a predikciókra jutunk akkor is, ha nyíltan a számítógép vélekedéseiről és vágyairól gondolkozunk, mint amikor a számítógép információs tárára és célmeghatározásaira gondolunk. Az elkerülhetetlen s érdekes tény az, hogy a mai legjobb sakkozó számítógépeknél a viselkedés intencionális magyarázata és bejóslása nemcsak bevett, hanem akkor is működik, ha viselkedésük predikciójára nincs más használható eljárás. Elég sikeresen tudjuk e komputereket intencionális rendszerekként kezelni, s ez független azoktól a megfontolásoktól, hogy milyen anyagból épültek, mi az eredetük, mi a helyük az erkölcsi ágensek közösségében (vagy éppen nincs is helyük ott), van-e tudatuk vagy öntudatuk, s hogy műveleteik determináltak vagy determinálatlanok-e. A stratégia alkalmazása mellett szóló döntés pragmatikus, s nem eredendően jó vagy rossz.

Darwin veszélyes ideája

Valamit észreveszek, és okot keresek hozzá: ez eredetileg a következőt jelenti: szándékot keresek benne és mindenekelőtt valakit, akinek valami szándéka van, egy szubjektumot, egy cselekvőt: minden történés cselekvés – valaha minden történésben szándékot láttak, ez a mi legrégebbi szokásunk. Vajon az állatoknak is van ilyen szokásuk? (Nietzsche: A hatalom akarása)

Az, hogy intencionális alapállást veszünk fel az evolúció terméke Dennett szerint. A komplexitás egy bizonyos foka felett a reprodukcióra képes önfenntartó rendszerek elkezdtek ilyen-olyan stratégiákat kialakítani, hogy megmaradjanak. Ezeket kedvenc elmefilozófusunk Micsoda elmék című könyvében így rendszerezi:

- Darwini teremtmények, melyek tkp. élesben tesztelődnak, hiszen vagy életben tudnak maradni tulajdonságaik által, vagy elpusztulnak

- Skinneri teremtmények, melyek a környezet ingereire reagálva adnak választ. Bizonyos inger-válasz párok megerősödnek a környezeti hatásokra, növelve ezzel a teremtmény túlélésének esélyeit, tehát itt már nem csak a készen kapott tulajdonságok számítanak, hanem az alkalmazkodás képessége is.

- Popperi teremtmények azok, melyek képesek mentális modelleket létrehozni, cselekvéseiket el tudják gondolni. Ez a darwini és skinneri sémánál sokkal kényelmesebb megoldás, hiszen a popperi teremtmények fejben is hibázhatnak, tökéletesíthetik terveiket, mielőtt cselekedniük kellene.

- Gregoryi teremtmények azok, melyek elméjüket képesek kiterjeszteni, környezetüket manipulálni tudják "elméleteik" kidolgozása és megvalósítása során. Nem kell nagy dologra gondolni, ilyen lehet pl. egy az elrejtett zsákmány helyét jelölő kereszt, vagy egy gyümölcs leverésére használt ág.

Az emlősök nagy része popperi teremtmény, a főemlősök pedig pályázhatnak a gregoryi teremtmény címre, ami a homályos leírás ellenére annyit tesz, intencionális ágens. Mit is jelent az intencionalitás? Alapvetően ami intencionális, az valami másra irányul. Az intencionális alapállásból úgy kezelünk egy entitást, mintha az racionális lenne s lennének szándékai, vágyai, törekvései egy adott cselekvés során. S való igaz, házi kedvenceink viselkedését is gyakran így magyarázzuk, tehát az intencionális alapállásból nem csak az emberekre tekintünk.

lennének szándékai, vágyai, törekvései egy adott cselekvés során. S való igaz, házi kedvenceink viselkedését is gyakran így magyarázzuk, tehát az intencionális alapállásból nem csak az emberekre tekintünk.

Dennett azonban csavar egyet az intencionalitás fogalmán, s bevezeti annak első- és magasabb rendű változatait. Az elsőrendű intencionális rendszereknek vannak elképzeléseik, törekvéseik, vágyaik és minden rendes jellemzőjük, ellenben ennek nincsenek tudatában. A másod- és magasabb rendű intencionális rendszerek viszont amolyan meta-rendszerek s tisztában vannak saját vágyaiknak, elképzeléseiknek, sőt másoknak is hasonlókat tulajdonítanak.

Attitűdök, nyelv, szimbólumok

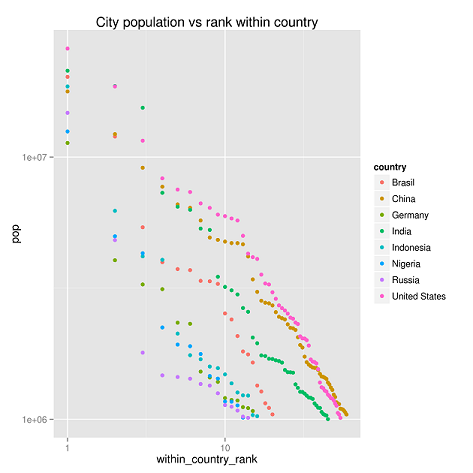

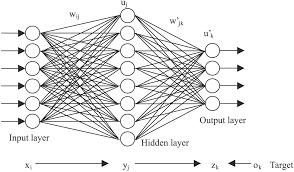

A másod- és magasabb rendű intencionalitás menthetetlenül összekapcsolódik a nyelvvel, hiszen az intencionális stratégiát nem tudjuk nélküle elkészíteni. Annyi azonban bizonyos, hogy a gregoryi teremtmények számára, mindegy hogy az intencionalitás mely fokán állnak, szimbólumokat kell használniuk, azaz, valami olyat, ami más helyett áll. Clark és Karmiloff-Smith The Cognizer's Innards című tanulmánya 1993-ban, a konnekcionizmus kellős közepén, hívta fel a figyelmet a szimbólumhasználat fontosságára és a skinneri teremtményekre igazított inger-válasz hálózatokat alkalmazó modellek korlátaira.

Hogyan is néz ki egy ilyen intencionális alapállás? Óhatatlanul olyan mondatokban fogalmazunk mint az alábbi (Denettől lopott) példák

- x azt hiszi, hogy p

- y arra törekszik, hogy q

- z azon töpreng, vajon r

A fentiekhez hasonló mondatokat a filozófusok propozícionális attitűdöknek nevezik. Vigyük ezt tovább!

- Nóri tudja, hogy Zoli szereti a krumplilángost.

- Zoli tudja, hogy Nóri tudja, hogy szereti a krumplilángost.

- Nóri tudja, hogy Zoli tudja, hogy Nóri tudja, szereti a krumplilángost.

Az "én tudom, hogy ő tudja" gondolatsorok persze általában véget szoktak érni, ha másért nem, hát időhiány miatt. De látható, hogy egyedül memóriánk és véges időnk szab határt az ilyen elmélkedéseknek. Fontos megjegyezni, hogy a fenti példákban egy-egy sémát használunk, az "X tudja, hogy Q" stb. propozíciók egy-egy mentális állapotra tekintenek úgy, mint egy objektumra!

Beszédaktusok, pragmatika, egyéb nagy szavak

Láthatjuk, ahhoz, hogy intelligensnek nevezhessünk valamit, intencionális álláspontra kell helyezkednünk, amikor interakcióba lépünk vele. Ahhoz, hogy igazán emberinek tekintsük, magasabb rendű intencionalitást kell tanúsítania. Ez nem csak azt jelenti, hogy mi propozícionális attitűdök formájában gondolkodunk róla, hanem a kommunikáció során is felmerül egymással szemben az intencionalitás feltételezése. Az olyan mondatok elhangzása során mint pl:

- Hozd nekem ide azt a szendvicset.

- Megbüntetlek, nem mehetsz el ma sehova.

- Értem a feladatot.

- Elnevezlek Padlinak!

- Megígérem, elviszlek moziba.

nem csupán a propozíciók jelentését kell megértenie egy intelligens ágensnek, hanem a velük kifejezett cselekvést is. Ez ilyen típusú állítások ún. az beszédaktusok, amik feltételezik hogy a bennük résztvevő ágensek intencionálisak.

De akkor most mi van a gépekkel?

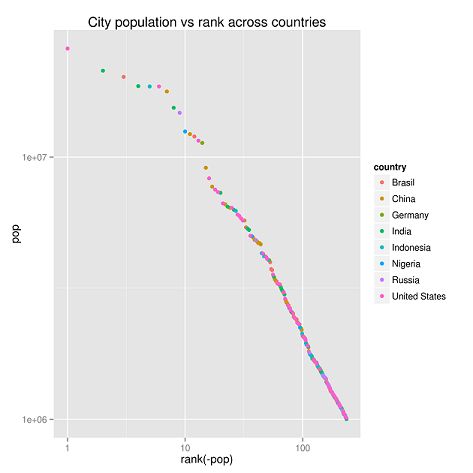

Láthattuk, a manapság divatos megközelítéseknél nem érdemes magasabb rendű intencionalitás után kutakodni - már amennyiben Dennett meggyőző számunkra. A dinamikus episztemikus logika "ezoterikus" tudománya pontosan azzal foglalkozik, hogyan lehet formálisan modellezni azt, hogy ágensek egymásnak hiteket, vágyakat, törekvéseket stb. tulajdonítanak. Hogyan lehet egy ilyen helyzetet modellezni? Vegyük a korábbi példánkban szereplő Nórit és a krumplilángost szerető Zolit. Egy zajos csatornán keresztül próbálják megbeszélni, hogy elmennek és keresnek egy éttermet ahol ehetnek. A csatorna zajos, de annyit tudunk róla, hogy kellő n számban ismételve előbb-utóbb átjut rajta egy üzenet. Formalizáljuk a helyzetet, Nórit és Zolit nevezzük át, egyikük legyen S (mint sender, azaz küldö vagy feladó), a másik pedig R (mint receiver, azaz fogadó vagy címzett). Vezessünk be egy modális operátort, K-t. Ks(a) és Kr(a) intuitív értelmezése csupán annyi, hogy s ágens tudja hogy a. Legyen X = [x1, ... xn] egy diszkrét üzenetekből álló sorozat amit S küld K-nak. Ditmarsch, van der Hoek és Kooi (p. 25) nyomán ekkor az alábbi protokollok határozzák meg a sikeres megállapodást.

S protokoll

S1 i :=0

S2 while true do

S3 begin read xi ;

S4 send xi until KsKr(xi);

S5 send “KsKr(xi)” until Ks Kr Ks Kr(xi)

S6 i := i + 1

S7 end

R protokoll

R2 when Kr(x0) set i :=0

R2 while true do

R3 begin write xi ;

R4 send “Kr(xi)” until KrKsKr(xi);

R5 send “KrKsKr(xi)” until Kr(xi+1)

R6 i := i + 1

R7 end

Látható, harmadrendű intencionalitás szükséges ahhoz, hogy mindkét fél tudja, megbeszélték a dolgot s biztosak legyenek abban, mindketten tudják miben állapodtak meg. Mielőtt azt hinnénk, erre csak az ember képes, lelombozzuk a kedélyeket! A fenti kis protokoll ún. alternáló bit protokoll működését írta le eredetileg! Persze akadnak ennél komolyabb szituációkra alkalmazható eszközök is a dinamikus episztemikus logika tárában!

Hogy lesz-e olyan android, akiről csak nehezen deríthető ki, hogy gép-e vagy ember, azt ma nem lehet megmondani. A kutatások gyerekcipőben járnak és rendkívül sok terület összekapcsolását kívánják meg. A Szárnyas fejvadász Tears in Rain monológjának szintjét elérő mesterséges intelligenciára még sokat kell várni, ha egyáltalán elérhető.

I've seen things you people wouldn't believe. Attack ships on fire off the shoulder of Orion. I watched C-beams glitter in the dark near the Tannhäuser Gate. All those moments will be lost in time, like tears in rain. … Time to die.