A mesterséges intelligencia programadó konferenciája 1956-ban nagyon optimista volt, akkor még úgy gondolták, pár évtized elegendő lesz az emberi intelligenciát elérő, vagy akár meg is haladó megoldások elkészítése. Ma, amikor már szoftver segített megoldani a négyszín-sejtést, a Watson megnyerte a Jeopardy! vetélkedőt és autonóm, vezető nélküli autókat tesztel több gyártó, azt hihetnénk, az álom szinte megvalósult. Ellenben autonóm robotokat továbbra sem vagyunk képesek készíteni, egy rendes arcfelismerő betanításához minimum a Facebook adatbázisával kell rendelkeznünk, a nyelvfeldolgozás terén pedig még egy óvodás képességeit sem tudja elérni egy-egy alkalmazás. Egyre többen gondolják úgy, hogy a továbblépéshez alaposan át kell gondolnunk azt, ahogyan eddig közelítettük a problémához, mindeközben egyre gyakrabban merül fel egy 18. századi filozófus, a jó öreg Kant neve.

Kezdeti optimizmus

Turing és Church munkájának gyümölcse az általános számítógép a második világháború alatt valósággá vált, ennek alapelveit a következő évtizedben Neumann tökéletesített és mind a tudományos, mind az üzleti életben megjelentek a komputerek. A mesterséges intelligenciát máig átható optimista paradigmát Churchland fogalmazta meg a legjobban:

The question that confronts the research program of AI, therefore, is not whether suitably programmed computers can simulate the continuing behavior produced by the computational procedures found in natural animals, including those found in humans. That question is generally regarded as settled. In principle, at least, they can. The important question is whether the activities that constitute conscious intelligence are all computational procedures of some kind or other. The guiding assumption of AI is that they are, and its aim is to contstruct actual programs that will simulate them. That is why the vast majority of AI workers have been concerned with writing programs rather than with building ever more novel forms of computing hardware. (Paul M. Churchland: Matter and Consciousness, p. 105)

Hideg napok

A mesterséges intelligencia története során eddig kilenc (!) "jégkorszak" (AI winter) volt, ami a kutatási pénzek befagyasztásával és az ipar elfordulásával járt. Részben ennek is köszönhető, hogy folyamatosan új név alatt jelenik meg ez a tudományterület. Az "artificial intelligence" a kilencvenes években "intelligent systems" néven éledt újjá, de a manapság divatos "machine learning" vagy az IBM Watson kapcsán felmelegített "cognitive computing" is ide sorolható, egyes kutatók pedig inkább besorolták magukat a "(computational) cognitive science" kategóriába (megúszva evvel az ipari alkalmazhatóság számonkérését).

Figyeljünk az agyra!

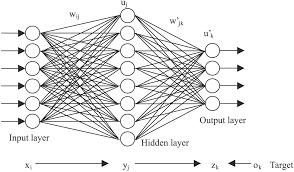

A neurális háló elmélete egyidős a számítógéppel. A első idealizált neuron modell McCulloch és Pitts írta le A logical calculus of the ideas immanent in nervous activity című dolgozatukban. Neumann eképpen foglalja össze ennek jelentőségét Az automaták általános és logikai elméletében:

McCulloch és Pitts elméletének fontos eredménye, hogy a fenti értelemben vett bármely olyan működés, amelyet véges számú "szó" segítségével logikailag szigorúan és egyértelműen egyáltalán definiálhatunk, ilyen formális neurális hálózattal meg is valósítható. [...] A McCulloch-Pitts-féle eredmény [...] bebizonyítja, hogy minden, amit kimerítően és egyértelműen szavakba lehet foglalni - alkalmas véges neuronhálózattal ipso facto realizálható is. Minthogy az állítás megfordítása nyilvánvaló, állíthatjuk, hogy bármely reális vagy elképzelt, teljesen és egyértelműen szavakba foglalható viselkedési mód leírásának a lehetőse és ugyanennek a véges formális neuronhálózattal való megvalósításának a lehetősége között nincs különbség. A két fogalom terjedelme egyenlő.

Neumann A számológép és az agy című írásában veti részletesebben össze a természetes és mesterséges automatákat, azaz az emberi agyat és a számítógépeket. A természetes automatákkal kapcsolatban külön kiemeli, hogy a mai szakzsargonnal élve meglepő módon jó hibatűrők, nem akasztja meg őket egy-egy "alkatrész" hiánya vagy a zavaros input. Megállapítja továbbá, hogy

[...] az adatok arra mutatnak, hogy természetes alkatelemekből felépített berendezések esetében nagyobb számú, bár lassúbb szerv alkalmazása részesíthető előnyben, míg mesterséges alkatelemekből felépített berendezések esetében előnyösebb, ha kevesebb, de gyorsabb szervet alkalmaznak. Így tehát azt várhatjuk, hogy egy hatékonyan megszervezett természetes automata (mint az emberi idegrendszer) minél több logikai (vagy információs) adat egyidejű felvételére és feldolgozására lesz berendezve, míg egy hatékonyan megszervezett nagy mesterséges automata (például egy nagy modern számológép) inkább egymás után látja majd el teendőit - egyszerre csak egy dologgal vagy legalábbis nem olyan sok dologgal foglalkozik. Röviden: a nagy és hatékony természetes automaták valószínűleg nagy mértékben párhuzamos működésűek, míg a nagy és hatékony mesterséges automaták inkább soros működésre rendezhetők be.

A sorozatos jégkorszakok közül külön figyelmet érdemel a hatvanas évek végén kezdődő periódus. Ekkor meszelik el a mai neurális hálók elődjének tartott Rosenblatt féle perceptron modellt használó kutatásokat. Azok egyszerű, a kezdetleges modellek hiába voltak ígéretesek, hardveresen nehéz volt megvalósítani azokat. Húsz évre ki is szorult a mainstreamből a neurális hálók elmélete.

A nyolcvanas években Paul Smolensky (nyelvész olvasóinknak az optimalitáselméletből lehet ismerős a neve) köré kezdtek szerveződni a konnekcionisták, akik a kor színvonalához képest már nagyon jó számítógépes modellekkel dolgoztak. A kétrészes Parallel Distributed Processingtanulmánykötetben összegezték munkáikat 1987-ben, melyet még ma is szívesen hivatkoznak a terület kutatói. A PDP csoport alapvetően Neumann gondolatát vitte tovább a párhuzamos feldolgozást illetően. A gyakorlatban egy-egy ún. szubszimbolikus kognitív folyamatot modelleztek (pl. számjegyek felismerése, szófelismerés, a legbonyolultabb és egyben legismertebb magasabb szintű folyamatot modellező kísérlet a Rumelhart és McCelland On the learning of past tenses of English verbs tanulmányban leírt modell). Habár nagyon sikeres volt a csoport és figyelemre méltó eredményeket értek el, a kutatási irányzat a kilencvenes években kiesett az ipar látóköréből és megmaradt akadémiai hobbinak.

2005-ben Hinton és Salakhutdinov Reducing the Dimensionality of Data with Neural Networks című tanulmánya után jelent meg a deep learning elnevezés (habár a paper még a deep autoencoder network kifejezést használja) a neurális háló egy új fajtájára. A deep learning arra utal, hogy a mesterséges neuronok több rétegbe szerveződve tanulnak. A hatvanas években még csak két, egy be- és egy kimeneti réteget használtak, a nyolcvanas években ezek közé iktattak be egy ún. hidden layert, de egészen a kétezres évek elejéig kellett várni arra, hogy algoritmikusan kezelhető legyen több réteg beiktatása. A deep learning szerencsés pillanatban lépet színre, hiszen vele együtt fejlődött ki a big data, azaz a hatalmas adatmennyiségek gyűjtésének, tárolásának és hatékony feldolgozásának területe is. Az igazi sikert az algoritmikus megoldások mellett a hardver és a rendelkezésre álló adatok mennyisége hozta meg. A Facebook arcfelismerő algoritmusa több milliárd felhasználó megtagelt fotóin tanulhatja az arcfelismerést, a Google alkalmazása a macska fogalmát tkp. a netre feltöltött összes cicás képet felhasználva tanulta meg. Fontos különbség még a hagyományos neurális hálók és a deep learning között, hogy a modern irányzat egyre inkább a nem-felügyelt (azaz a felcímkézett tréningadatok használata nélküli) megközelítés felé mozdult el.

Figyelemre méltó, hogy az agy egy nagyon leegyszerűsített modelljével mi mindenre képesek a kutatók. Ugyanakkor felmerül a kérdés, mennyire gazdaságos, mennyire életszerű pl. több évtizedig gyűjteni fotók milliárdjait egy arcfelismerő létrehozásához? Tényleg csak egy Google vagy Facebook nagyságú, hihetetlen adatmennyiségen ülő cég képes ilyen dolgokra? Az arcfelismerést, az autóvezetést és a többi intelligenciát igénylő feladatot észrevétlenül végezzük, annyira könnyedén, hogy bele sem gondolunk milyen nehéz ezt replikálni. Hogy lehetséges ez?

Kant és a neocortex

Amikor hazamegyünk, kinyitjuk a lakás ajtaját, levesszük a kabátunkat, felakasztjuk, levesszük a cipőnket, belebújunk kedvenc papucsunkba, becsoszogunk a nappaliba, lehuppanunk a kanapéra és feltesszük lábunkat a dohányzóasztalra, odanyúlunk az újságunkért és a táviránytóval bekapcsoljuk a hifit csupa rutincselekvést végzünk. Ha valamelyik kreatív családtagunk odébb tette például a fogast, akkor lehet hogy kabátunk a földre fog hullani, mert megszokásból, oda sem nézve akartuk felakasztani. Bosszankodunk egy kicsit, de folytatjuk rutinunkat. Igen ám, de a kanapéra ülve észrevesszük, lábunk nem éri el a dohányzóasztalt! Azon már meg sem lepődünk hogy újságunk helyett prospektusok között turkálunk a hifi meg már nincs a szobában.

Jeff Hawkins, a Numenta alapítója szerint a fenti szituáció remekül példázza hogy agyunk tulajdonképpen egy prediktív rendszer. A rutinunk belénk ültette a lakásunkról kialakított képet. Agyunk megtanulta hogy hol van a fogas, a távkapcsoló, az újságunk stb. Amikor valami váratlan történik, pl. leesik a kabátunk akkor egy eltérő mintázatot tapasztalunk. A fenti szituációban ekkor körbenézünk, de azt találjuk hogy minden más változatlan, ezért agyunk visszaáll a megszokott dolgok előrejelzésére. Amikor azonban nem tudjuk lábunkat kényelmes pozícióba helyezni, hirtelen elkezdünk figyelni jobban a különbségekre és agyunk szinte várja a következő anomáliát. A intelligencia Hawkins szerint nem más, mint az, hogy agyunk egyfajta rendet vetít a világra, elrendezi és megjósolja hogyan fog alakul és reagál a nem várt helyzetekre. Ez nagyon úgy hangzik, mint Kant gondolatai a Prolegomenában:

Tehát egyedül az érzéki szemlélet formája révén vagyunk képesek arra, hogy a dolgokat a priori szemléljük, ámde ekként csak úgy ismerjük meg az objektumokat, ahogyan azok nekünk (érzékeinkben) megjelenhetnek, nem pedig úgy, ahogyan magukban vannak.

Hawkins On Intelligence című könyvében amellett érvel, hogy a mesterséges intelligencia eddig tulajdonképpen tévúton járt a Churchland által megfogalmazott paradigmát követve. Az agy hatékonyan oldja meg a gépi tanulás által nagyon nehezen megközelített problémákat, ezért érdemes tanulmányozni működését. Hawkins az agy általános működése helyett a neocortex modelljét célozza meg, mivel ez felel a magasabb, emberi intelligenciáért. A modell neve Hierarchical Temportal Memory, vagy újabban Cortical Learning Algorithm. Ez a modell is tkp. egy deep learning modell, hiszen mesterséges neuronok szerveződnek benne szintekbe. Azonban jelentősen el is tér a neurális hálók elméletétől, ugyanis nagyon nagy szerepet kap a modellben az idő és az ún. online learning (azaz valós időben történő tanulás és előrejelzés - igazi előfutára a Sparse Distributed Memory elmélete). Ahhoz, hogy hatékonyan tudjuk modellezni a neocortex működését, el kell szakadnunk a hagyományos számítási modellektől! A neocortex ugyanis a PDP iskola által is hangoztatott párhuzamos, megosztott feldolgozás szerint működik. Sajnos a Numenta még nem kezdett hardvert gyártani, de hagyományos Neumann architektúrára elérhető algoritmusuk open source formája NuPIC néven itt.

Hardver vs szoftver

Hawkins nagyon várja a hagyományos architektúráktól eltérő számítógépek megjelenését, habár jelenlegi termékei simán elfutnak az öreg paradigma vasain is. Nincs ezen mit csodálkozni, hiszen pl. a Bluebrain projekt, ami az emberi agy (illetve a neocortex) teljes komputációs modelljének megalkotását tűzte ki céljának, is "hagyományos" szuperszámítógépek segítségével dolgozik.

Nagyon régóta izgatja a szakembereket egy, az agy felépítéséhez hasonló számítógép megalkotása, ám valahogy ideáig nem sikerült az elmélet keretein túljutni. Carver Mead, a VLSI áramkörök tervezésének egyik forradalmi megújítója már a nyolcvanas évektől intenzíven foglalkozott a ma neuromorphic computing néven emlegetett irányzattal, mely célja a neuronokhoz hasonló számítási egységek fizikai megvalósítása. Ennek ellenére az egyetlen igazán jelentős hardver a 2009-ben megjelent Neurogrid, ami fizikailag modellezi a neocortex egy részét, ami egymillió neuront és egy hatmilliárd szinapszist jelent, mindezt a Bluebrain energiaigényének egymilliomod részéből lehet üzemeltetni.

Jelenleg sokkal egyszerűbb a hagyományos hardvereket használni. Az általános számítógép szépségét az adja, hogy programozással egyedivé tehetjük, más rendszereket modellezhetünk rajta. Ellenben, ha meg akarjuk érteni azt, miképp képes agyunk intelligens viselkedést produkálni, szükségünk van fizikai modellekre is, hiszen ezek megépítése egyben az agy felépítésére vonatkozó elméleteink tesztelését is jelenti.